Minference 1.0

紹介 :

MInference 1.0 は、長シーケンス処理のプリフィル段階を高速化することを目的とした疎計算手法です。長文脈注意行列における3つの独自の模式を識別することにより、長文脈大型言語モデル(LLM)に対する動的疎注意機構を実現し、1Mトークンのプリフィル段階を高速化しつつ、LLMの能力、特に検索能力を維持します。

ターゲットユーザー :

MInference 1.0は、大量のデータと長文脈情報を処理する必要がある研究者や開発者、特に自然言語処理と機械学習の分野で活躍する方々に適しています。計算資源の使用を最適化することで、大型言語モデルがより迅速にテキストを処理および生成することを可能にし、効率的なテキスト生成と検索能力が必要なアプリケーションシナリオに最適です。

使用シナリオ

Q&Aタスクにおいて、MInference 1.0は正確な回答を迅速に検索および生成できます。

プログラミングタスクにおいて、MInference 1.0は開発者がコードを迅速に記述および理解するのを支援できます。

マルチホップQ&Aタスクにおいて、MInference 1.0は複雑な文脈情報を処理し、一貫性のある回答を提供できます。

製品特徴

動的疎注意機構により、長文脈LLMのプリフィル段階を高速化し、処理速度を最大10倍に向上させます。

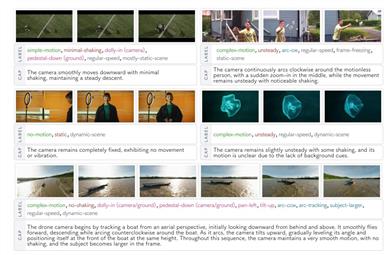

動的疎注意をA-shape、Vertical-Slash、Block-Sparseの3つのモードに分類し、最適なヘッドパターンを見つけるKernel-Aware Sparse Pattern Searchアルゴリズムを設計しました。

オンライン近似手法と最適化されたGPUカーネルを導入することで、最小限のオーバーヘッドでLLM推論を高速化します。

最適化された推論コードライブラリを提供し、単一のA100上でLLaMAスタイルのモデルを用いた1Mトークンのプリフィル推論を実現します。

InfiniteBench、RULER、PG-19、Needle in a Haystackなど、複数のベンチマークテストでMInferenceを評価し、LLMの実質的な文脈処理能力を評価しました。

マイクロベンチマークテストを通じて、提案された3つの注意機構のパフォーマンスとFlashAttentionとの比較を示しました。

Needle in a Haystackタスクにおける異なる文脈ウィンドウとプロンプト内の重要な情報の位置に関するパフォーマンス評価を含む、様々なモデルと手法においてMInferenceをテストしました。

使用チュートリアル

ステップ1:MInference 1.0のオンラインデモにアクセスするか、コードをダウンロードします。

ステップ2:ドキュメントの説明に従って、必要な環境と依存関係を設定します。

ステップ3:長文脈データまたはモデルを読み込みます。

ステップ4:MInference 1.0のAPIまたはコマンドラインツールを使用して、データのプリフィル処理を実行します。

ステップ5:最適化された推論プロセスを実行し、処理速度と結果の品質を観察します。

ステップ6:必要に応じてパラメータを調整して、最適なパフォーマンスと精度を得ます。

おすすめAI製品

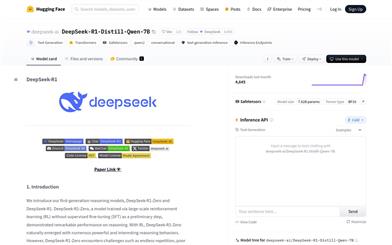

Deepseek R1 Distill Qwen 7B

DeepSeek-R1-Distill-Qwen-7Bは、Qwen-7Bを蒸留最適化し、強化学習によって最適化された推論モデルです。数学、コード、推論タスクにおいて優れた性能を発揮し、高品質な推論チェーンと解決策を生成できます。大規模な強化学習とデータ蒸留技術により、推論能力と効率性が大幅に向上しており、複雑な推論と論理分析が必要なシナリオに適しています。

モデルトレーニングとデプロイメント

138.8K

Deepseekモデル互換性チェック

DeepSeekモデル互換性チェックは、デバイスが様々な規模のDeepSeekモデルを実行できるかどうかを評価するためのツールです。デバイスのシステムメモリ、ビデオメモリなどの構成と、モデルのパラメータ数、精度ビット数などの情報を組み合わせることで、モデル実行の予測結果を提供します。このツールは、開発者や研究者がDeepSeekモデルをデプロイする際に適切なハードウェアリソースを選択する上で非常に重要であり、ハードウェア不足による実行問題を事前に回避するのに役立ちます。DeepSeekモデル自体は、自然言語処理などで広く利用されている高度な深層学習モデルであり、効率的で正確な特徴を持っています。このチェックツールを使用することで、ユーザーはDeepSeekモデルをより効果的にプロジェクト開発や研究に活用できます。

モデルトレーニングとデプロイメント

102.9K