Gemma 2B 10M

紹介 :

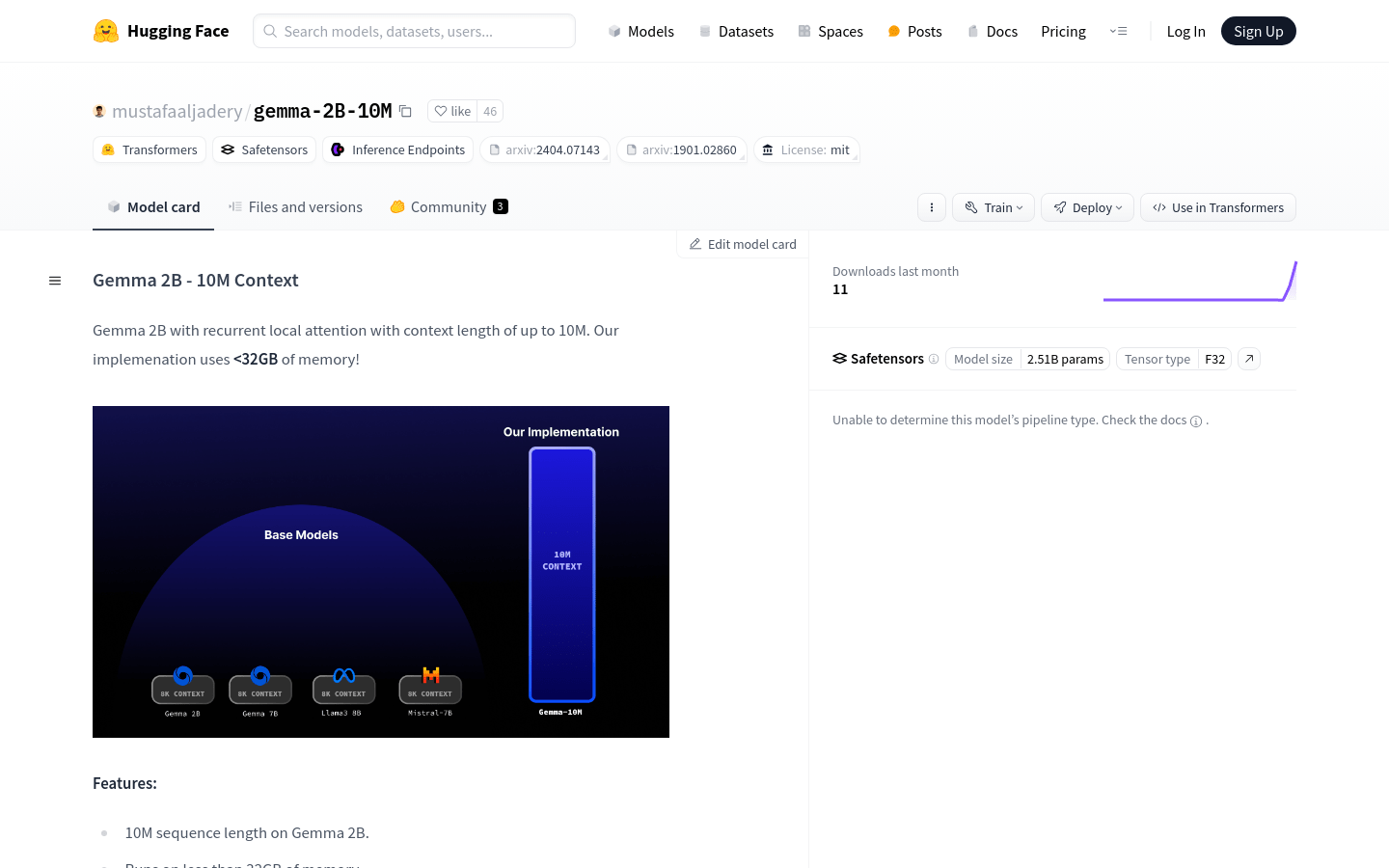

Gemma 2B - 10M Contextは、革新的なアテンション機構の最適化により、32GB未満のメモリで最大10Mトークンのシーケンスを処理できる大規模言語モデルです。Transformer-XL論文に着想を得た循環局所アテンション技術を採用し、大規模言語タスク処理のための強力なツールです。

ターゲットユーザー :

["大量のテキストデータ処理を必要とする研究者や開発者向け","長文生成、要約、翻訳などの言語タスクに適している","高性能とリソース最適化を求める企業ユーザーにとって魅力的"]

使用シナリオ

Gemma 2B - 10M Contextを使用して『ハリー?ポッター』シリーズの要約を生成する

教育分野において、学術論文の要約を自動生成する

ビジネス分野において、製品説明や市場分析のためのテキストコンテンツを自動生成する

製品特徴

最大10Mトークンのシーケンス長に対応するテキスト処理能力

32GB未満のメモリで動作し、リソース使用量を最適化

CUDA向けに最適化されたネイティブ推論性能

循環局所アテンションによるO(N)メモリ計算量

200ステップの早期チェックポイント(性能向上のため、より多くのトークンを学習する計画)

AutoTokenizerとGemmaForCausalLMを使用してテキスト生成

使用チュートリアル

ステップ1:Hugging FaceからGemma 2B - 10M Contextモデルをインストールします。

ステップ2:特定の指示テキストに合わせてmain.pyの推論コードを修正します。

ステップ3:AutoTokenizer.from_pretrainedを使用してモデルのトークナイザーを読み込みます。

ステップ4:GemmaForCausalLM.from_pretrainedを使用してモデルを読み込み、データ型をtorch.bfloat16に指定します。

ステップ5:指示テキストを設定します(例:'Summarize this harry potter book...')

ステップ6:勾配を計算せずにgenerate関数を使用してテキストを生成します。

ステップ7:生成されたテキストを出力して結果を確認します。

おすすめAI製品

Deepmind Gemini

Geminiは、Google DeepMindが開発した次世代人工知能システムです。テキスト、画像、ビデオ、音声、コード間のシームレスな相互作用をサポートし、マルチモーダル推論を実行できます。言語理解、推論、数学、プログラミングなど、複数の分野において従来のシステムを凌駕し、現在までに開発された最も強力なAIシステムの一つとなっています。エッジコンピューティングからクラウドコンピューティングまで、様々なニーズに対応できる3つの異なる規模のバージョンがあります。Geminiは、クリエイティブデザイン、ライティングアシスタント、質問応答、コード生成など、幅広い分野で活用できます。

AIモデル

11.4M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M