VLOGGER

紹介 :

VLOGGERは、一枚の人物入力画像からテキストと音声で駆動される話す人間のビデオを生成する手法です。これは、近年の生成拡散モデルの成功に基づいています。私たちの手法は、1) ランダムな人物から3Dモーションへの拡散モデル、そして2) 時間と空間制御を強化した、新規の拡散ベースアーキテクチャによるテキストから画像へのモデルを含みます。この手法は、可変長の高品質ビデオを生成でき、人間の顔と体の高度な表現方法によって容易に制御できます。以前の研究とは異なり、私たちの手法は個人ごとにトレーニングする必要がなく、顔検出や切り抜きにも依存しません。全身像(顔や唇だけでなく)を生成し、人間らしいコミュニケーションに必要な幅広いシーン(例えば、見える体幹や多様な体格)を考慮しています。

ターゲットユーザー :

静止画一枚から動的ビデオを生成する必要がある場面、例えばビデオ編集や人物入れ替えなどに適しています。

使用シナリオ

リアルな人体ビデオの生成

既存ビデオコンテンツの編集

ビデオ翻訳

製品特徴

テキストと音声駆動のビデオ生成

高品質ビデオ生成

高い制御性

身体運動シミュレーション

顔と姿勢の制御

おすすめAI製品

Sora

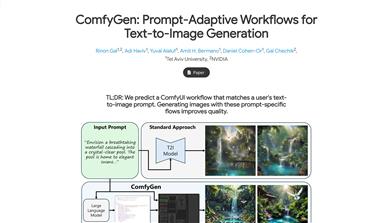

Soraは、大規模データで学習されたテキスト制御型ビデオ生成拡散モデルです。1分間の高解像度ビデオ生成が可能で、幅広い視覚データの種類と解像度に対応します。ビデオと画像の圧縮潜在空間で学習することで、時空間的位置パッチに分解し、スケーラブルなビデオ生成を実現しています。また、三次元の一貫性やインタラクションなど、物理世界とデジタル世界の挙動をある程度シミュレートできる能力を示しており、高性能シミュレータの開発に向けて、ビデオ生成モデルの大規模化が有望であることを示唆しています。

AI動画生成

17.0M

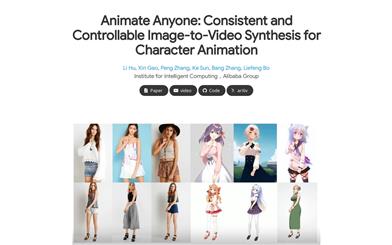

Animate Anyone

Animate Anyoneは、駆動信号から静止画像を基にキャラクタビデオを生成することを目指しています。拡散モデルの力を活用し、キャラクタアニメーション用に特化した新しいフレームワークを提案します。参照画像における複雑な外観特徴の一貫性を維持するため、空間的注意機構を用いて詳細な特徴を統合するReferenceNetを設計しました。制御可能性と連続性を確保するため、キャラクタの動作をガイドする効率的なポーズガイド機構を導入し、ビデオフレーム間の滑らかなクロスフェードを実現する効果的な時間モデリング手法を採用しています。トレーニングデータの拡張により、任意のキャラクタのアニメーション作成が可能になり、他の画像からビデオへの変換手法と比較して、キャラクタアニメーションにおいて優れた結果を得ています。さらに、ファッションビデオと人間のダンス合成のベンチマークにおいて最先端の結果を達成しました。

AI動画生成

11.4M