Vista LLaMA

紹介 :

Vista-LLaMAは、ビデオ理解の向上を目指した高度なビデオ言語モデルです。視覚トークンと言語トークン間の均等な距離を維持することで、生成されるテキストの長さに関係なく、ビデオの内容と無関係なテキストの生成を削減します。この手法は、計算された視覚とテキストトークン間の注意重み付けにおいて相対位置エンコーディングを省略し、テキスト生成プロセスにおける視覚トークンの影響をより顕著にします。Vista-LLaMAは、順次視覚プロジェクターも導入しており、現在のビデオフレームを言語空間のトークンに投影することで、ビデオ内の時間的関係を捉えながら、視覚トークンの必要性を削減します。複数のオープンなビデオ質疑応答ベンチマークにおいて、このモデルは他の手法を大幅に上回る性能を示しています。

ターゲットユーザー :

ビデオの内容に関する深い理解と分析が必要な研究者や開発者向けです。

使用シナリオ

研究者はVista-LLaMAを用いて、複雑なビデオコンテンツの深い理解と分析を行っています。

開発者はVista-LLaMAを用いて、ビデオ質疑応答システムにおける回答の精度を向上させています。

コンテンツクリエイターはVista-LLaMAを用いて、革新的なビデオコンテンツの生成を行っています。

製品特徴

視覚トークンと言語トークンの等距離関係を維持する

ビデオの内容と無関係なテキストの生成を削減する

順次視覚プロジェクターでビデオ内の時間的関係を捉える

おすすめAI製品

Sora

Soraは、大規模データで学習されたテキスト制御型ビデオ生成拡散モデルです。1分間の高解像度ビデオ生成が可能で、幅広い視覚データの種類と解像度に対応します。ビデオと画像の圧縮潜在空間で学習することで、時空間的位置パッチに分解し、スケーラブルなビデオ生成を実現しています。また、三次元の一貫性やインタラクションなど、物理世界とデジタル世界の挙動をある程度シミュレートできる能力を示しており、高性能シミュレータの開発に向けて、ビデオ生成モデルの大規模化が有望であることを示唆しています。

AI動画生成

17.0M

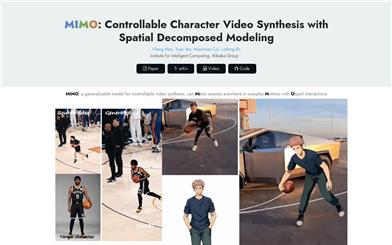

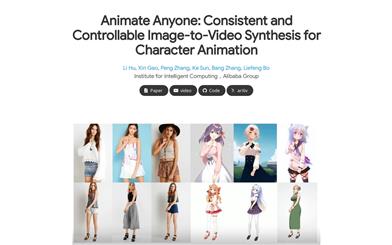

Animate Anyone

Animate Anyoneは、駆動信号から静止画像を基にキャラクタビデオを生成することを目指しています。拡散モデルの力を活用し、キャラクタアニメーション用に特化した新しいフレームワークを提案します。参照画像における複雑な外観特徴の一貫性を維持するため、空間的注意機構を用いて詳細な特徴を統合するReferenceNetを設計しました。制御可能性と連続性を確保するため、キャラクタの動作をガイドする効率的なポーズガイド機構を導入し、ビデオフレーム間の滑らかなクロスフェードを実現する効果的な時間モデリング手法を採用しています。トレーニングデータの拡張により、任意のキャラクタのアニメーション作成が可能になり、他の画像からビデオへの変換手法と比較して、キャラクタアニメーションにおいて優れた結果を得ています。さらに、ファッションビデオと人間のダンス合成のベンチマークにおいて最先端の結果を達成しました。

AI動画生成

11.4M