Tarsier

简介 :

Tarsier 是由字节跳动研究团队开发的一系列大规模视频语言模型,旨在生成高质量的视频描述,并具备强大的视频理解能力。该模型通过两阶段训练策略(多任务预训练和多粒度指令微调)显著提升了视频描述的精度和细节。其主要优点包括高精度的视频描述能力、对复杂视频内容的理解能力以及在多个视频理解基准测试中取得的 SOTA(State-of-the-Art)结果。Tarsier 的背景基于对现有视频语言模型在描述细节和准确性上的不足进行改进,通过大规模高质量数据训练和创新的训练方法,使其在视频描述领域达到了新的高度。该模型目前未明确定价,主要面向学术研究和商业应用,适合需要高质量视频内容理解和生成的场景。

需求人群 :

Tarsier 适合需要高质量视频内容生成和理解的用户,包括视频内容创作者、研究人员、视频平台开发者以及需要自动化视频描述的商业用户。它能够帮助用户快速生成详细的视频描述,提升视频内容的可访问性和用户体验。

使用场景

视频内容创作者可以使用 Tarsier 自动生成视频的详细描述,节省时间和精力。

研究人员可以利用 Tarsier 的模型架构和训练方法进行视频语言模型的研究和改进。

视频平台可以集成 Tarsier 提供自动视频描述功能,提升用户体验和内容可访问性。

产品特色

生成高质量视频描述,能够详细描述视频中的事件、动作和场景。

支持多任务预训练,涵盖视频描述、视频问答等多种任务。

采用多粒度指令微调,提升模型对不同复杂度视频的理解能力。

在多个视频理解基准测试中取得 SOTA 结果,包括 MVBench、NeXT-QA 等。

提供 DREAM-1K 视频描述基准测试数据集,用于评估模型性能。

支持多种输入格式,包括视频、图像和 GIF 文件。

提供在线演示和开源代码,方便开发者进行研究和部署。

使用教程

1. 创建 Python 3.9 的虚拟环境(如果尚未安装):`conda create -n tarsier python=3.9`

2. 克隆 Tarsier 代码仓库:`git clone https://github.com/bytedance/tarsier.git`

3. 进入项目目录并运行安装脚本:`cd tarsier && bash setup.sh`

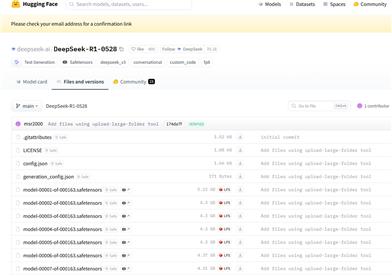

4. 下载模型权重文件,可以从 Hugging Face 获取:`Tarsier-7b` 或 `Tarsier-34b`

5. 准备输入视频文件,例如 `assets/videos/coffee.gif`

6. 运行快速启动脚本生成视频描述:`python3 -m tasks.inference_quick_start --model_name_or_path <模型路径> --instruction 'Describe the video in detail.' --input_path <视频路径>`

精选AI产品推荐

国外精选

Pika

Pika是一个视频制作平台,用户可以上传自己的创意想法,Pika会自动生成相关的视频。主要功能有:支持多种创意想法转视频,视频效果专业,操作简单易用。平台采用免费试用模式,定位面向创意者和视频爱好者。

视频生成

18.7M

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系统。它能够进行多模态推理,支持文本、图像、视频、音频和代码之间的无缝交互。Gemini在语言理解、推理、数学、编程等多个领域都超越了之前的状态,成为迄今为止最强大的AI系统之一。它有三个不同规模的版本,可满足从边缘计算到云计算的各种需求。Gemini可以广泛应用于创意设计、写作辅助、问题解答、代码生成等领域。

AI模型

11.4M