Qwen2 VL 72B

简介 :

Qwen2-VL-72B是Qwen-VL模型的最新迭代,代表了近一年的创新成果。该模型在视觉理解基准测试中取得了最新的性能,包括MathVista、DocVQA、RealWorldQA、MTVQA等。它能够理解超过20分钟的视频,并可以集成到手机、机器人等设备中,进行基于视觉环境和文本指令的自动操作。除了英语和中文,Qwen2-VL现在还支持图像中不同语言文本的理解,包括大多数欧洲语言、日语、韩语、阿拉伯语、越南语等。模型架构更新包括Naive Dynamic Resolution和Multimodal Rotary Position Embedding (M-ROPE),增强了其多模态处理能力。

需求人群 :

Qwen2-VL-72B的目标受众是研究人员、开发者和企业,他们需要一个强大的视觉语言模型来处理图像和视频理解任务。该模型的多语言支持和多模态处理能力使其成为全球用户的理想选择,尤其是在需要理解和操作视觉信息的场景中。

使用场景

使用Qwen2-VL-72B进行数学问题的图像识别和解答

在长视频中进行内容创作和问答系统的开发

集成到机器人中,实现基于视觉指令的自动导航和操作

产品特色

支持各种分辨率和比例的图像理解

能够理解超过20分钟的视频,用于高质量的视频问答、对话、内容创作等

集成到移动设备和机器人中,实现基于视觉环境和文本指令的自动操作

支持多语言文本理解,包括欧洲语言、日语、韩语、阿拉伯语、越南语等

Naive Dynamic Resolution,处理任意图像分辨率,提供更类人的视觉处理体验

Multimodal Rotary Position Embedding (M-ROPE),增强1D文本、2D视觉、3D视频位置信息的处理能力

使用教程

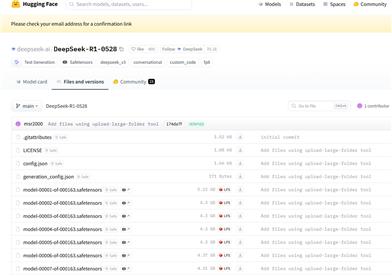

1. 安装最新版本的Hugging Face transformers库,使用命令:pip install -U transformers

2. 访问Qwen2-VL-72B的Hugging Face页面,了解模型详情和使用指南

3. 根据需要下载模型文件,并在本地或云端环境中加载模型

4. 使用模型进行图像或视频的输入,获取模型输出的结果

5. 根据应用场景,对模型输出进行后处理,如文本生成、问答回答等

6. 参与社区讨论,获取技术支持和最佳实践

7. 如果需要,对模型进行进一步的微调,以适应特定的应用需求

精选AI产品推荐

国外精选

Pika

Pika是一个视频制作平台,用户可以上传自己的创意想法,Pika会自动生成相关的视频。主要功能有:支持多种创意想法转视频,视频效果专业,操作简单易用。平台采用免费试用模式,定位面向创意者和视频爱好者。

视频生成

18.7M

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系统。它能够进行多模态推理,支持文本、图像、视频、音频和代码之间的无缝交互。Gemini在语言理解、推理、数学、编程等多个领域都超越了之前的状态,成为迄今为止最强大的AI系统之一。它有三个不同规模的版本,可满足从边缘计算到云计算的各种需求。Gemini可以广泛应用于创意设计、写作辅助、问题解答、代码生成等领域。

AI模型

11.4M