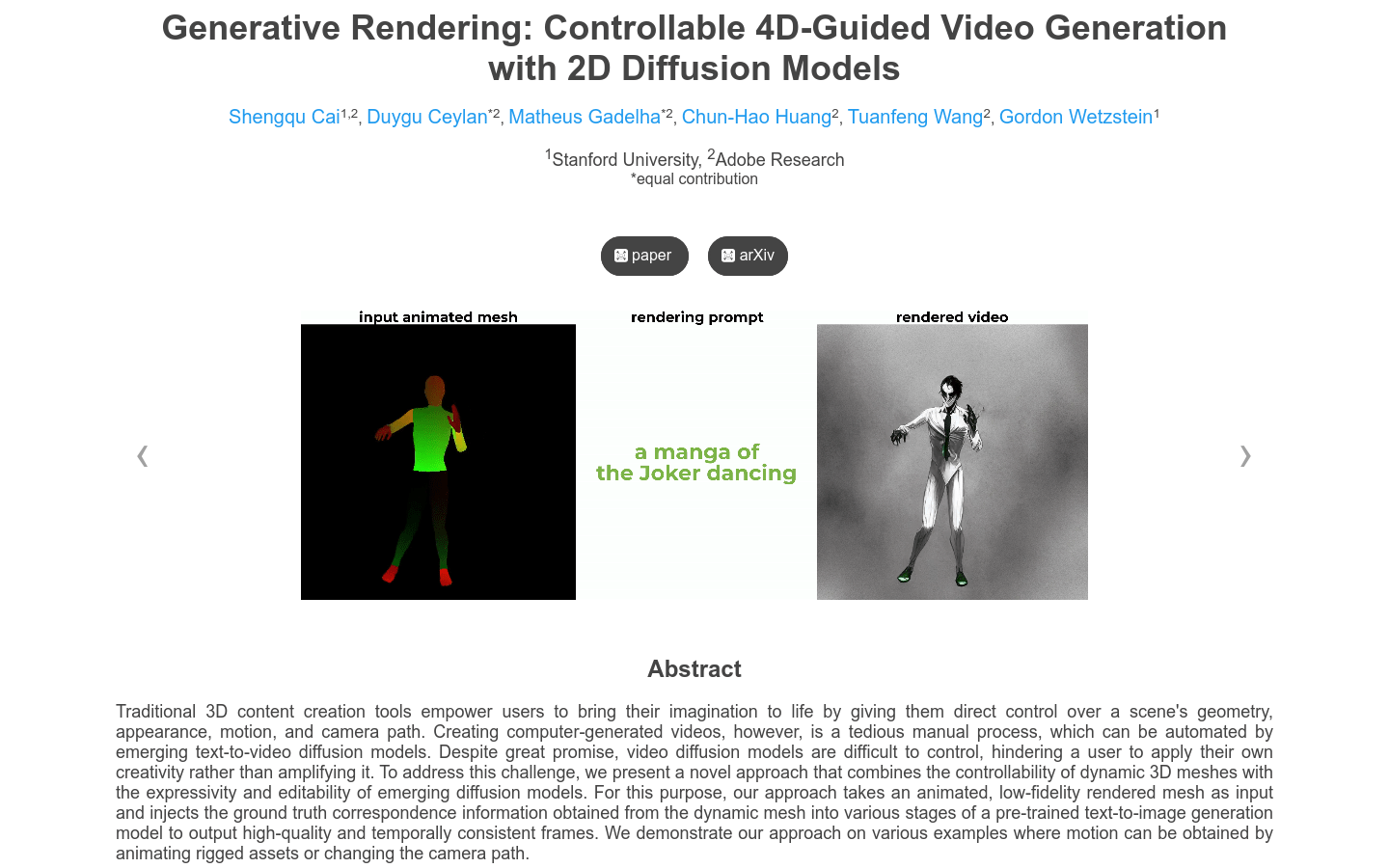

Generative Rendering:2D Mesh

简介 :

传统的3D内容创作工具赋予用户直接控制场景的几何形状、外观、动作和摄像机路径,从而将他们的想象变为现实。然而,创建计算机生成的视频是一个繁琐的手动过程,可以通过新兴的文本到视频扩散模型实现自动化。尽管前景广阔,视频扩散模型难以控制,限制了用户应用自己的创造力,而不是放大它。为了解决这一挑战,我们提出了一种新颖的方法,将动态3D网格的可控性与新兴扩散模型的表现力和可编辑性相结合。为此,我们的方法以动画化的低保真度渲染网格作为输入,并将从动态网格获得的地面真实对应信息注入预训练的文本到图像生成模型的各个阶段,以输出高质量和时间一致的帧。我们在各种示例上演示了我们的方法,其中动作可以通过对绑定资产进行动画化或改变摄像机路径来获得。

需求人群 :

适用于需要生成控制视频的场景,例如动画制作、特效制作等

使用场景

动画制作:利用生成渲染模型创建逼真的动画场景

特效制作:使用该模型生成特效视频片段

影视后期制作:应用于电影或电视节目的后期特效制作

产品特色

接受来自动画3D场景的UV和深度贴图作为输入

使用深度条件的ControlNet生成对应帧,同时利用UV对应关系保持一致性

初始化每个对象UV空间中的噪声,然后将其渲染到每个图像中

对于每个扩散步骤,首先为一组关键帧使用扩展注意力并提取它们的预处理和后处理注意力特征

将后处理注意力特征投影到UV空间并统一

最后,使用扩展注意力的输出与关键帧的预处理特征以及关键帧的UV组合后处理特征的加权组合生成所有帧

精选AI产品推荐

Sora

Sora是一个基于大规模训练的文本控制视频生成扩散模型。它能够生成长达1分钟的高清视频,涵盖广泛的视觉数据类型和分辨率。Sora通过在视频和图像的压缩潜在空间中训练,将其分解为时空位置补丁,实现了可扩展的视频生成。Sora还展现出一些模拟物理世界和数字世界的能力,如三维一致性和交互,揭示了继续扩大视频生成模型规模来发展高能力模拟器的前景。

AI视频生成

17.2M

Animate Anyone

Animate Anyone旨在通过驱动信号从静态图像生成角色视频。我们利用扩散模型的力量,提出了一个专为角色动画量身定制的新框架。为了保持参考图像中复杂外观特征的一致性,我们设计了ReferenceNet来通过空间注意力合并详细特征。为了确保可控性和连续性,我们引入了一个高效的姿势指导器来指导角色的动作,并采用了一种有效的时间建模方法,以确保视频帧之间的平滑跨帧过渡。通过扩展训练数据,我们的方法可以为任意角色制作动画,与其他图像到视频方法相比,在角色动画方面取得了出色的结果。此外,我们在时尚视频和人类舞蹈合成的基准上评估了我们的方法,取得了最先进的结果。

AI视频生成

11.8M