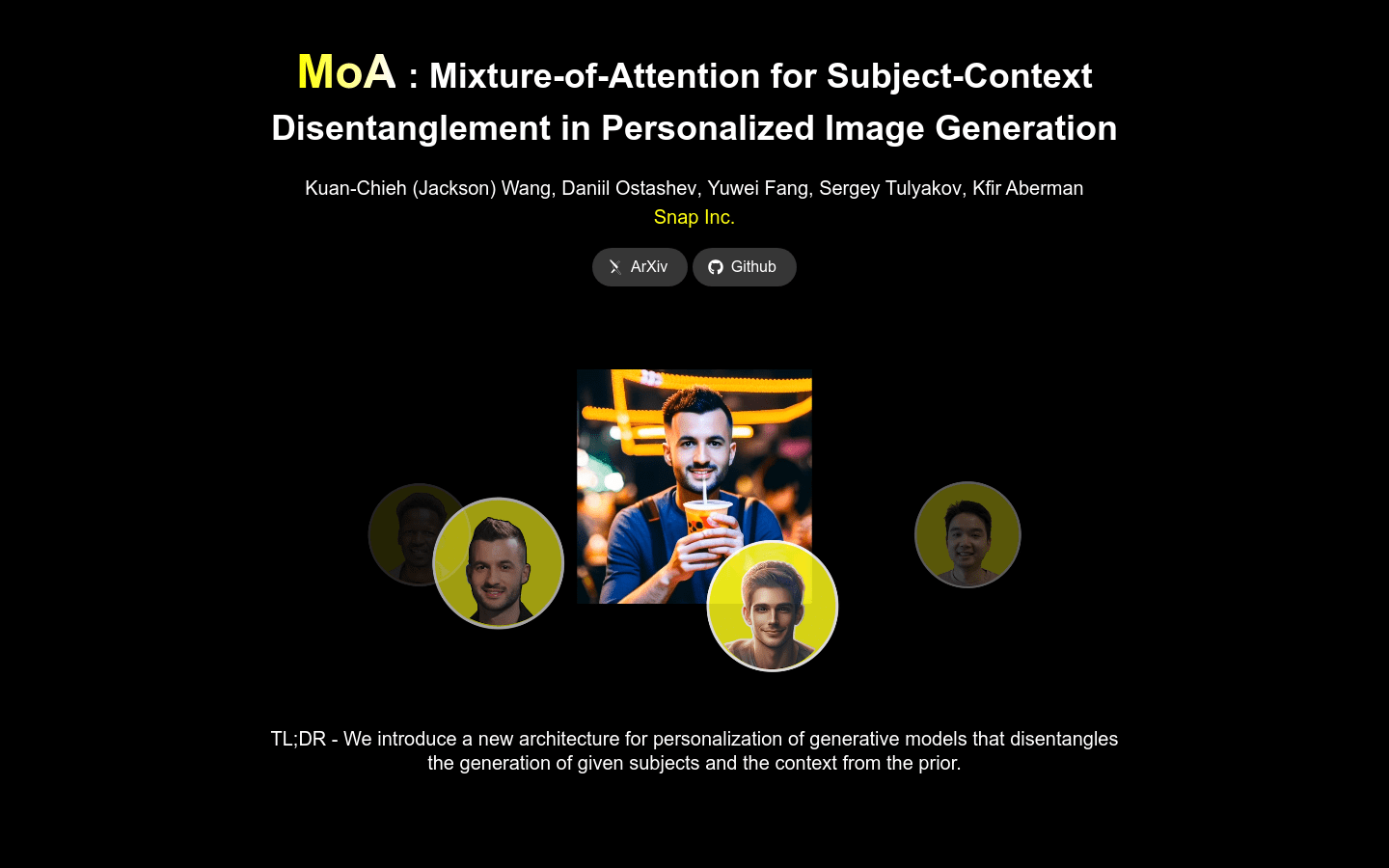

Mixture Of Attention (MoA)

簡介 :

Mixture-of-Attention (MoA) 是一種用於個性化文本到圖像擴散模型的新架構,它通過兩個注意力路徑——個性化分支和非個性化先驗分支——來分配生成工作負載。MoA 設計用於保留原始模型的先驗,同時通過個性化分支最小干預生成過程,該分支學習將主題嵌入到先驗分支生成的佈局和上下文中。MoA 通過一種新穎的路由機制管理每層像素在這些分支之間的分佈,以優化個性化和通用內容創建的混合。訓練完成後,MoA 能夠創建高質量、個性化的圖像,展示多個主題的組成和互動,與原始模型生成的一樣多樣化。MoA 增強了模型的先有能力與新增強的個性化干預之間的區別,從而提供了以前無法實現的更解耦的主題上下文控制。

需求人群 :

MoA 可用於個性化圖像生成,特別是在需要在圖像中嵌入特定主題並保持高質量和多樣性的場景中。

使用場景

將用戶上傳的照片中的面孔替換為另一個人的臉

生成具有特定姿勢和表情的個性化角色圖像

在保持背景一致性的同時,通過改變初始隨機噪聲來生成不同主題的圖像

產品特色

個性化圖像生成

主題和上下文解耦

高質量圖像生成

多主題組合與互動

個性化分支和非個性化先驗分支

像素分佈優化

精選AI產品推薦

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系統。它能夠進行多模態推理,支持文本、圖像、視頻、音頻和代碼之間的無縫交互。Gemini在語言理解、推理、數學、編程等多個領域都超越了之前的狀態,成為迄今為止最強大的AI系統之一。它有三個不同規模的版本,可滿足從邊緣計算到雲計算的各種需求。Gemini可以廣泛應用於創意設計、寫作輔助、問題解答、代碼生成等領域。

AI模型

11.4M

中文精選

剪映dreamina

剪映Dreamina是抖音旗下的AIGC工具,用戶可以根據文本內容生成由AI生成的創意圖,支持修整圖片大小比例和模板類型。未來會用於抖音的圖文或短視頻的內容創作,豐富抖音在AI創造方面的內容庫。

AI圖像生成

9.1M