Meta Lingua

紹介 :

Meta Linguaは、研究向けに設計された軽量で効率的な大規模言語モデル(LLM)のトレーニングおよび推論ライブラリです。変更しやすいPyTorchコンポーネントを使用しており、研究者は新しいアーキテクチャ、損失関数、およびデータセットを試すことができます。このライブラリは、エンドツーエンドのトレーニング、推論、および評価を実現し、モデルの速度と安定性をより深く理解するためのツールを提供することを目的としています。Meta Linguaはまだ開発中ですが、このコードベースの使用方法を示す複数のサンプルアプリケーションが既に提供されています。

ターゲットユーザー :

自然言語処理と機械学習の分野の研究者、開発者、学生を対象としています。Meta Linguaの柔軟性と使いやすさにより、新しいLLMアーキテクチャとトレーニング戦略を探求するための理想的なツールとなっています。

使用シナリオ

研究者はMeta Linguaを使用して、テキスト生成タスクを実行するためのカスタムの大規模言語モデルをトレーニングする

開発者はこのライブラリを使用して、マルチGPU環境でモデルのパフォーマンスとリソース使用率を最適化する

学生はMeta Linguaを使用して、大規模言語モデルの構築とトレーニング方法を学ぶ

製品特徴

PyTorchコンポーネントを使用してモデルを構築し、新しいアーキテクチャを容易に変更および実験する

データ並列処理、モデル並列処理、アクティベーションチェックポイントなどの複数の並列化戦略をサポート

分散型トレーニングをサポートし、複数のGPUでモデルトレーニングを実行可能

LLMの事前学習用データローダーを含む

パフォーマンス分析ツールを統合し、モデルのメモリと計算効率を計算するのに役立つ

モデルチェックポイント管理をサポートし、異なる数のGPUでモデルを保存およびロード可能

実験の設定と反復処理を容易にするための構成ファイルとコマンドラインパラメータを提供

使用チュートリアル

1. Meta Linguaのコードベースをローカルにクローンする

2. コードベースのディレクトリに移動し、設定スクリプトを実行して環境を作成する

3. 作成された環境をアクティブにする

4. 提供された構成ファイルまたはカスタム構成を使用してトレーニングスクリプトを開始する

5. トレーニングプロセスを監視し、必要に応じて構成パラメータを調整する

6. 評価スクリプトを使用して、指定されたチェックポイントでモデルを評価する

7. 分析ツールを使用して、モデルのパフォーマンスとリソース使用状況を確認する

おすすめAI製品

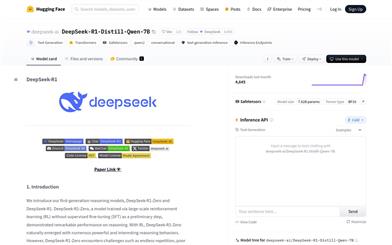

Deepseek R1 Distill Qwen 7B

DeepSeek-R1-Distill-Qwen-7Bは、Qwen-7Bを蒸留最適化し、強化学習によって最適化された推論モデルです。数学、コード、推論タスクにおいて優れた性能を発揮し、高品質な推論チェーンと解決策を生成できます。大規模な強化学習とデータ蒸留技術により、推論能力と効率性が大幅に向上しており、複雑な推論と論理分析が必要なシナリオに適しています。

モデルトレーニングとデプロイメント

138.0K

Deepseekモデル互換性チェック

DeepSeekモデル互換性チェックは、デバイスが様々な規模のDeepSeekモデルを実行できるかどうかを評価するためのツールです。デバイスのシステムメモリ、ビデオメモリなどの構成と、モデルのパラメータ数、精度ビット数などの情報を組み合わせることで、モデル実行の予測結果を提供します。このツールは、開発者や研究者がDeepSeekモデルをデプロイする際に適切なハードウェアリソースを選択する上で非常に重要であり、ハードウェア不足による実行問題を事前に回避するのに役立ちます。DeepSeekモデル自体は、自然言語処理などで広く利用されている高度な深層学習モデルであり、効率的で正確な特徴を持っています。このチェックツールを使用することで、ユーザーはDeepSeekモデルをより効果的にプロジェクト開発や研究に活用できます。

モデルトレーニングとデプロイメント

102.7K