VALL E 2

紹介 :

VALL-E 2は、マイクロソフトアジア研究院が開発した音声合成モデルです。反復的知覚サンプリングとグループ化符号化モデリング技術により、音声合成の堅牢性と自然さを大幅に向上させました。このモデルは、テキストを自然な音声に変換でき、教育、エンターテインメント、多言語コミュニケーションなど様々な分野で活用でき、アクセシビリティの向上やクロスリンガルフローの強化に貢献します。

ターゲットユーザー :

VALL-E 2は、教育分野の音声教材制作、エンターテインメント産業における音声キャラクター生成、多言語コミュニケーションにおける音声翻訳など、高品質な音声合成を必要とする企業や研究機関に適しています。その高い自然さと話者類似性により、ユーザーエクスペリエンスの向上とシームレスなコミュニケーションに大きく貢献します。

使用シナリオ

失語症患者向けの音声生成による日常コミュニケーション支援

教育分野における、外国語学習者向けの自然な発音の音声教材提供

エンターテインメント産業における、ビデオゲームキャラクター向けの高臨場感音声生成によるゲーム体験向上

製品特徴

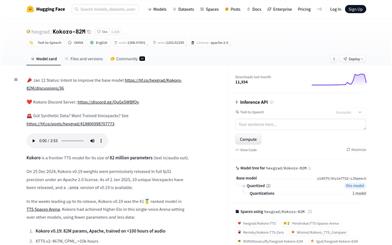

離散符号化による音声大規模モデルを用いて、強力なコンテキスト学習能力を発揮

わずか3秒の音声プロンプトで、パーソナライズされた音声合成が可能

反復的知覚サンプリング技術により、元のカーネルサンプリングプロセスを改善し、安定したデコードを実現し、無限ループの問題を回避

グループ化符号化モデリング技術により、シーケンス長を効果的に短縮し、推論速度を向上

LibriSpeechとVCTKデータセットにおいて、ゼロショットTTS性能が人間レベルに匹敵

元の話者音声と非常に一致した正確で自然な音声を生成可能

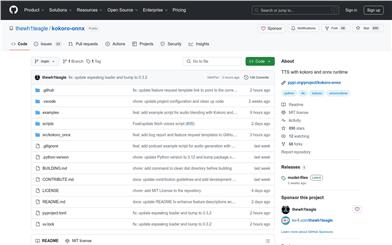

使用チュートリアル

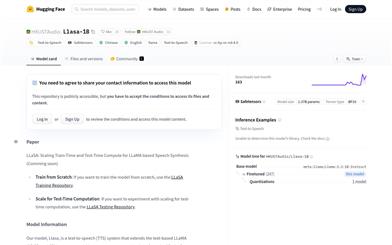

ステップ1:VALL-E 2モデルの使用権限を取得する

ステップ2:3秒間の話者音声プロンプトを用意する

ステップ3:音声に変換したいテキストを入力する

ステップ4:VALL-E 2モデルを用いて音声合成を行う

ステップ5:モデルパラメータを調整して音声の自然さと話者類似性を最適化する

ステップ6:合成された音声ファイルを生成して出力する

ステップ7:合成された音声を該当するシーンや製品に適用する

おすすめAI製品

高品質新製品

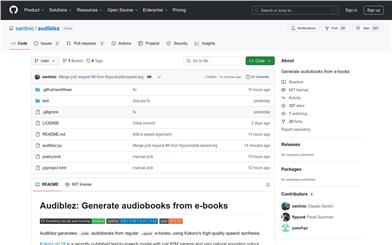

Fish Audioテキスト読み上げ

テキスト読み上げ技術は、テキスト情報を音声に変換する技術であり、補助読書、音声アシスタント、オーディオブック制作など幅広い分野で活用されています。人間の自然な音声に似た合成音声により、情報取得の利便性を高め、特に視覚障碍者や目が使えない状況下で非常に役立ちます。

テキスト読み上げ音声

8.7M

Elevenlabs

ElevenLabsは、最先端のテキスト読み上げと音声クローンソフトウェアです。必要な音声、スタイル、言語で高品質のオーディオを生成できます。コンテンツクリエイターでも小説家でも、当社のAI音声ジェネレーターは魅力的なオーディオ体験のデザインを可能にします。AI音声ジェネレーターで、コンテンツを文字を超えたレベルに高めましょう。

テキスト読み上げ音声

2.3M