Comfyui LumaAI API

简介 :

ComfyUI-LumaAI-API是一个为ComfyUI设计的插件,它允许用户直接在ComfyUI中使用Luma AI API。Luma AI API基于Dream Machine视频生成模型,由Luma开发。该插件通过提供多种节点,如文本到视频、图像到视频、视频预览等,极大地丰富了视频生成的可能性,为视频创作者和开发者提供了便捷的工具。

需求人群 :

视频创作者、开发者和AI爱好者。这个插件特别适合需要快速生成视频内容或进行视频编辑的用户,它通过提供易于使用的API接口,使得视频生成过程更加高效和直观。

使用场景

用户可以使用LumaText2Video节点从文本提示生成教育视频。

开发者可以利用LumaImage2Video节点将静态图像转化为动态视频,用于商业广告。

内容创作者可以通过LumaInterpolateGenerations节点在不同视频版本之间创建平滑过渡。

产品特色

LumaAIClient节点:创建LumaAI客户端。

LumaText2Video节点:从文本提示生成视频。

LumaImage2Video节点:从图像生成视频,图像可用作视频的第一帧或最后一帧。

LumaInterpolateGenerations节点:在两个生成的视频之间进行插值。

LumaExtendGeneration节点:扩展视频生成,可选择在生成前或后进行扩展。

LumaPreviewVideo节点:预览视频,视频将被调整为768px以在ComfyUI中更好地显示。

ImgBBUpload节点:上传图像到ImgBB并返回URL,因为Luma API目前仅支持图像URL作为输入。

使用教程

安装ComfyUI-LumaAI-API插件到ComfyUI的custom_nodes目录。

克隆GitHub仓库:git clone https://github.com/lumalabs/ComfyUI-LumaAI-API.git

安装依赖:cd ComfyUI-LumaAI-API && pip install -r requirements.txt

配置Luma AI API密钥,可以选择将其添加到config.ini文件中。

启动ComfyUI并开始使用LumaAI API节点。

精选AI产品推荐

Sora

Sora是一个基于大规模训练的文本控制视频生成扩散模型。它能够生成长达1分钟的高清视频,涵盖广泛的视觉数据类型和分辨率。Sora通过在视频和图像的压缩潜在空间中训练,将其分解为时空位置补丁,实现了可扩展的视频生成。Sora还展现出一些模拟物理世界和数字世界的能力,如三维一致性和交互,揭示了继续扩大视频生成模型规模来发展高能力模拟器的前景。

AI视频生成

17.2M

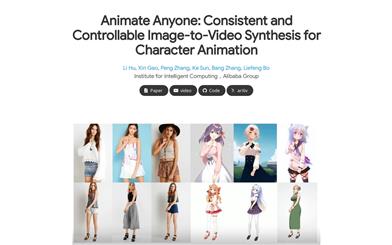

Animate Anyone

Animate Anyone旨在通过驱动信号从静态图像生成角色视频。我们利用扩散模型的力量,提出了一个专为角色动画量身定制的新框架。为了保持参考图像中复杂外观特征的一致性,我们设计了ReferenceNet来通过空间注意力合并详细特征。为了确保可控性和连续性,我们引入了一个高效的姿势指导器来指导角色的动作,并采用了一种有效的时间建模方法,以确保视频帧之间的平滑跨帧过渡。通过扩展训练数据,我们的方法可以为任意角色制作动画,与其他图像到视频方法相比,在角色动画方面取得了出色的结果。此外,我们在时尚视频和人类舞蹈合成的基准上评估了我们的方法,取得了最先进的结果。

AI视频生成

11.8M