Emotalk3d

Overview :

EmoTalk3D是一个专注于3D虚拟人头合成的研究项目,它通过收集多视角视频、情感注释和每帧3D几何数据来解决传统3D人头合成中存在的视角一致性和情感表达不足的问题。该项目提出了一种新颖的方法,通过训练EmoTalk3D数据集,实现了情感可控的3D人头合成,具有增强的唇部同步和渲染质量。EmoTalk3D模型能够生成具有广泛视角和高渲染质量的3D动画,同时捕捉到动态面部细节,如皱纹和微妙表情。

Target Users :

EmoTalk3D的目标受众是从事3D动画、虚拟现实、增强现实等领域的研究人员和开发者。它适合需要生成具有高度真实感和情感表达的3D虚拟角色的场景,例如电影制作、游戏开发、虚拟助手等。

Use Cases

电影制作中使用EmoTalk3D生成具有情感表达的3D角色。

游戏开发者利用EmoTalk3D创建具有丰富表情的虚拟角色。

虚拟助手通过EmoTalk3D技术提供更自然的人机交互体验。

Features

情感内容分离编码器,解析输入语音中的内容和情感特征。

语音到几何网络(S2GNet),预测动态3D点云。

高斯优化和完成模块,建立标准外观。

几何到外观网络(G2ANet),基于动态3D点云合成面部外观。

渲染模块,将动态高斯渲染成自由视角动画。

数据集EmoTalk3D,提供情感注释的多视角人头数据。

How to Use

1. 访问EmoTalk3D项目页面,了解项目背景和技术细节。

2. 下载并安装必要的软件和库,以运行EmoTalk3D模型。

3. 准备或获取音频输入,确保音频包含所需的情感表达。

4. 使用EmoTalk3D模型处理音频输入,生成3D几何序列。

5. 根据生成的3D几何数据,通过G2ANet合成面部外观。

6. 利用渲染模块将合成的外观渲染成动态的3D动画。

7. 根据需要调整模型参数,优化渲染效果和情感表达。

Featured AI Tools

Sora

Sora是一个基于大规模训练的文本控制视频生成扩散模型。它能够生成长达1分钟的高清视频,涵盖广泛的视觉数据类型和分辨率。Sora通过在视频和图像的压缩潜在空间中训练,将其分解为时空位置补丁,实现了可扩展的视频生成。Sora还展现出一些模拟物理世界和数字世界的能力,如三维一致性和交互,揭示了继续扩大视频生成模型规模来发展高能力模拟器的前景。

AI视频生成

17.2M

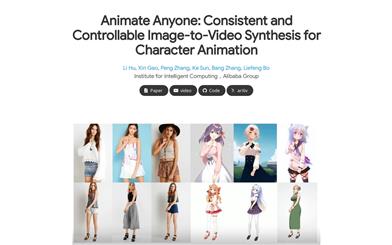

Animate Anyone

Animate Anyone旨在通过驱动信号从静态图像生成角色视频。我们利用扩散模型的力量,提出了一个专为角色动画量身定制的新框架。为了保持参考图像中复杂外观特征的一致性,我们设计了ReferenceNet来通过空间注意力合并详细特征。为了确保可控性和连续性,我们引入了一个高效的姿势指导器来指导角色的动作,并采用了一种有效的时间建模方法,以确保视频帧之间的平滑跨帧过渡。通过扩展训练数据,我们的方法可以为任意角色制作动画,与其他图像到视频方法相比,在角色动画方面取得了出色的结果。此外,我们在时尚视频和人类舞蹈合成的基准上评估了我们的方法,取得了最先进的结果。

AI视频生成

11.8M